1新智元報道

在目標追蹤界泰斗、UC Merced 楊明玄教授的指導下,香港城市大學、阿德萊德大學、SenseNet的研究人員從深度學習的角度出發,提出了一種端到端的跟蹤模型,將特徵提取和響應生成融合在深度學習框架中,只採用單層卷積的端到端結構,就達到了利用深度特徵的傳統協同濾波器的效果。

在此基礎上,研究人員還引入殘差學習來有效維持模型在目標運動中的預測性能,這也是殘差學習的概念首次被用於目標跟蹤領域。實驗表明,新方法在標準的數據庫中取得了state-of-the-art的精度效果。該工作將於10月末在意大利威尼斯舉辦的計算機視覺頂會ICCV 2017中面向全球學者進行呈現。新智元獨家搶先對其內容進行詳細報道。

目標跟蹤(Object Tracking)一直是計算機視覺中應用廣泛而且富有挑戰性的問題。簡單說,目標跟蹤就是在一段視頻中,給定第一幀目標物體的位置和大小信息(標定框)後,讓跟蹤算法在後續的每一幀中對目標物體的位置和大小進行預測。

跟蹤算法實時確定目標物體狀態,為進一步智能分析提供了先決條件。目標跟蹤技術在安防、人機交互和無人駕駛等一系列領域中都有應用。

安防監控場景中行人跟蹤和軌跡預測

人機交互中對人手勢的跟蹤和識別

無人駕駛中臨近車輛的跟蹤和跟隨行駛

在實際應用中,目標跟蹤算法的效果受很多因素的制約,本質是由於物體在視頻中出現的各種無法預測的變化。典型的制約因素包括:

☟ 物體在視頻中從初始幀到當前幀,光照情況發生了劇烈的變化

☟ 物體在視頻中運動姿態發生了很大的變化

☟ 物體在視頻中出現了局部遮擋或全局遮擋的情況

☟ 物體在視頻中與相似背景的混雜(目標汽車的尾燈和迎面而來汽車的頭燈)

☟ 物體在視頻中的大小發生了顯著的變化

現實中制約目標跟蹤的因素還有很多。為了克服這些因素帶來的不良影響,目前主流的跟蹤算法多采用深度卷積特徵和傳統的協同濾波相結合的方式。雖然在性能上得到了提升,但是深度學習的架構優勢並未得到充分的利用(比如HCFT[1],DeepSRDCF[2],C-COT[3])。

另一方面,有一些深度學習模型將跟蹤問題轉化為了處理物體檢測(MDNet[4])和校驗(SINT[5])的思路。但是,這種方法在不利用額外的跟蹤視頻做訓練的前提下,其精度無法匹及協同濾波。

下面要介紹的這項工作,從深度學習的角度出發,提出了一種端到端的跟蹤模型,並用殘差式學習來有效維持模型在目標運動中的預測性能,在標準的數據庫中取得了state-of-the-art的精度效果。有鑑於其性能優異,方法創新——首次將殘差學習應用於目標追蹤,該工作已被ICCV 2017接收。

“CREST”(Convolutional RESidual learning for visual Tracking),也有勇攀高峰之意

充分挖掘深度學習在追蹤算法研究中的優勢,構建端到端的深度模型做預測

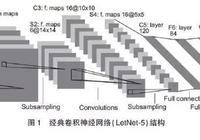

雖然深度學習方法在物體檢測和識別方面已經取得了優異的效果,但是在物體跟蹤的算法研究中,主流方向依然集中在協同濾波器的各種拓展。縱然使用深度學習,也只是將深度卷積特徵作為傳統特徵的替代,提升跟蹤的精度。

協同濾波的優勢在於其在頻率域的快速運算和對物體位置的密集估計特性,這一優點一直吸引研究人員在此框架內不斷做新的探索。但是,協同濾波方法並非沒有侷限。首先,協同濾波跟輸入特徵沒有關聯,這樣一個結構並沒有對跟蹤這個問題有專門的改進。其次,協同濾波器的在線更新方法是人先驗設定的,並沒有隨著物體的在線變化過程而做自適應的調整。

那麼,有沒有方法改進上述問題呢?從本質上說,協同濾波器是一個與物體特徵做卷積從而生成二維高斯響應的過程。訓練協同濾波器的係數,即為衡量卷積後的響應與真實高斯響應偏差多少的操作。

協同濾波將物體迴歸為二維高斯核,其峰值即為物體中心位置。

研究人員發現,這樣一種訓練方式,可以用L2損失函數訓練單層卷積層來等價替換。採用單層卷積替代協同濾波的好處是,特徵提取和高斯響應的生成可以緊密地結合在一起,為端到端的訓練和預測提供了基礎。此外,由於訓練卷積層可以採用梯度下降的優化方法,就能夠對整個框架為了實現跟蹤任務進行一體的優化。另外,在線模型更新的過程也是網絡根據物體的變化情況做自適應的調整。相比於傳統協同濾波計算封閉解的方法和固定更新方法的人為先驗設置,深度學習的優化框架無疑是更優越的。

端到端的預測和優化

同時,用單層卷積層代替協同濾波器,對特徵的卷積操作也從頻域轉換到了時域,從而有效的克服了傅里葉變換帶來的邊界影響問題。

首次將殘差學習用於目標追蹤,提升網絡預測質量

有了端對端建模,研究人員成功將物體從輸入圖像迴歸成二維的高斯響應圖,峰值即為物體的位置。那麼在理想情況下,網絡會準確地對物體進行迴歸。

而當前文提到的制約因素,比如光照、目標物體大小發生了劇烈的變化,目標物體與背景相似時,網絡將無法預測的準確二維高斯響應。這時,峰值發生了變化,導致物體位置預測失敗。

為了提升網絡預測的高斯響應圖的質量,本文提出了殘差式學習的概念。具體講,在單層卷積作為基本映射(Base mapping)的基礎上,並行地引入了殘差映射(Residual mapping),用這種方法來捕獲基本映射和真實高斯響應之間的差異。

殘差式學習的框架,由基本映射和殘差映射組成

在物體處於平穩狀態時,基本映射的輸出和真實值的高斯響應很相似,此時殘差網絡幾乎沒有什麼輸出。在物體處於不穩定的狀態時,殘差網絡能夠很好的捕獲基本映射的輸出和真實值高斯響應的差異,通過加法操作補充基本映射的輸出,從而使整個網絡的輸出更逼近真實值,更好地對目標進行定位。

空間域的殘差式學習

同時,本文也利用了第一幀的初始信息,將其殘差補充於隨後幀的預測中,幫助基本映射生成更優的高斯響應。

時域和空域的殘差式學習

下圖為殘差式結構提升網絡預測高斯響應的直觀顯示。

實驗評估結果

經過實驗,作者發現新的方法只採用單層卷積的端到端結構,達到了利用深度特徵的傳統協同濾波器的效果。不僅如此,時空域的殘差結構還提升了基本映射的精度。與其他跟蹤方法相比,該方法在標準數據庫上取得了state-of-the-art 的精度結果。

單層卷積(基本映射)與利用深度特徵的傳統濾波器效果相似

同時,在引入了時空域的殘差式結構後,跟蹤效果逐步提升。

此外,在標準數據庫OTB[6]上,本文提出的CREST方法取得的state-of-the-art的效果。更多的實驗結果在文中進行了呈現。

跟蹤效果展示

下面是直觀的跟蹤效果展示,在標準數據庫OTB[6]上比較了新方法CREST和目前主流的跟蹤方法Staple[7],SRDCF[8],MDNet[4],C-COT[3]。以下為這些跟蹤算法在一些挑戰性場景下的效果。

☟ 當跟蹤物體被遮擋時,CREST(紅框)能夠有效地對物體進行定位。C-COT(綠框)也行。

☟ 當跟蹤目標出現相似物體的干擾時,MDNet(藍框)無法有效區分,從而使得跟蹤目標丟失。

☟ 當跟蹤目標產生劇烈的運動變化時,CREST(紅框)可以有效地進行跟蹤。MDNet(藍框)也能。

☟ 當跟蹤目標與背景相似時,CREST(紅框)和MDNet(藍框)可以進行有效地區分。

可以看到,本文提出的CREST算法在挑戰性的場景中,性能優於目前主流的跟蹤算法。

結語

本文將利用深度學習框架,對目標跟蹤進行了端到端的建模,從而能夠進行全局的優化和更新。針對目標物體遇到的挑戰性的場景,本文提出的殘差式網絡結構能夠從時域和空域捕獲高斯響應圖的不足,並在整個網絡中彌補單層卷積網絡的帶來的侷限性。因此,跟蹤的精度在標準數據庫上得到了顯著的提升。

本文已開源,項目地址請查閱:

www.cs.cityu.edu.hk/~yibisong/iccv17/index.html

參考文獻

[1]. HCFT: Hierarchical Convolutional Features for Visual Tracking. Chao Ma, Jia-Bin Huang, Xiaokang Yang, and Ming-Hsuan Yang. ICCV 2015.

[2]. DeepSRDCF: Convolutional features for correlation filter based visual tracking. Martin Danelljan, Gustav Hager, Fahad Shahbaz Khan, and Michael Felsberg. ICCV 2015 workshops.

[3]. C-COT: Beyond correlation filters: Learning continuous convolution operators for visual tracking. Martin Danelljan, Andreas Robinson, Fahad Shahbaz Khan, and Michael Felsberg. ECCV 2016.

[4]. MDNet: Learning Multi-Domain Convolutional Neural Networks for Visual Tracking. Hyeonseob Nam, and Bohyung Han. CVPR 2016.

[5]. SINT: Siamese Instance Search for Tracking. Ran Tao, Efstratios Gavves, and Arnold W.M. Smeulders. CVPR 2016.

[6]. OTB: Online Object Tracking: A benchmark. Yi Wu, Jongwoo Lim, and Ming-Hsuan Yang. CVPR 2013.

[7] Staple: Complementary Learners for Real-Time Tracking. Luca Bertinetto, Jack Valmadre, Stuart Golodetz, Ondrej Miksik, and Philip Torr. CVPR 2016.

[8] SRDCF: Learning spatially regularized correlation filters for visual tracking. Martin Danelljan, Gustav Hager, FahadShahbaz Khan, and Michael Felsberg. ICCV 2015.

點擊閱讀原文可查看職位詳情,期待你的加入~

![AI開發]基於深度學習的視頻多目標跟蹤實現 AI開發]基於深度學習的視頻多目標跟蹤實現](http://image.zixundingzhi.com/-Q6lK4fsnkmEkn0xiRFpKNrgHwk=/200x140/full/e5ea76c8c42b883c9982bebff0e2b28dfff5e3f8)